摘要:

...

摘要:

... 1月15日,澎湃科技(www.thepaper.cn)获悉,AI独角兽企业MiniMax上海稀宇科技有限公司(以下简称“MiniMax”)发布并开源新一代01全新系列模型。该系列模型包含基础语言大模型MiniMax-Text-01和视觉多模态大模型MiniMax-VL-01。MiniMax称该系列模型可以实现高效超长文本输入。MiniMax认为,2025年将是Agent高速发展的关键年份,无论是单Agent系统还是多Agent系统,都需要更长的上下文来支持持续记忆和大量通信。

据了解,MiniMax-01系列模型首次大规模实现线性注意力机制,传统Transformer架构不再是唯一的选择。

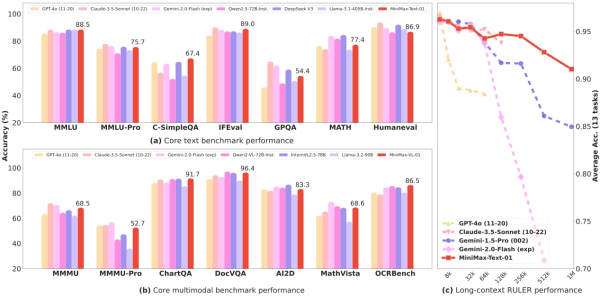

MiniMax-01系列模型核心性能在多项任务评测结果显示结果

目前领先的大语言模型大都基于Transformer架构,而Transformer核心的自注意力机制是其计算成本的重要来源。为了优化计算效率,MiniMax研究社区提出了稀疏注意力、低秩分解和线性注意力等许多技术。通过使用线性注意力,原生Transformer的计算复杂度可从二次复杂度大幅下降到线性复杂度,在处理长输入的时候具有非常高的效率。

据了解,该模型的参数量高达4560亿,其中单次激活459亿。模型综合性能比肩海外顶尖模型,同时能够高效处理全球最长400万token的上下文,是GPT-4o的32倍,Claude-3.5-Sonnet的20倍。

MiniMax认为,2025年将是Agent高速发展的关键年份,无论是单Agent系统还是多Agent系统,都需要更长的上下文来支持持续记忆和大量通信。MiniMax-01系列模型的推出,正是为了满足这一需求,迈出建立复杂Agent基础能力的第一步。

此外,MiniMax声称受益于架构的创新、效率的优化、集群训推一体的设计以及内部大量并发算力复用,得以用业内最低的价格区间提供文本和多模态理解的API,标准定价是输入token1元/百万token,输出token8元/百万token。

目前,MiniMax-01系列开源模型已应用于MiniMax旗下产品海螺AI,并在全球范围内上线,企业与个人开发者可前往MiniMax开放平台使用API。

还没有评论,来说两句吧...